SorayaPaniagua Ⓢ

Un blog de tecnología desde 2009

Inteligencia artificial: de machine learning al inquietante deep learning

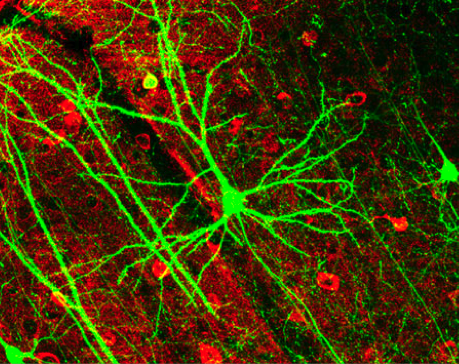

Célula piramidal e interneuronas. Imagen CC BY 2.5 Generic

Para bien o para mal, hoy en día lo realmente importante a nivel tecnológico y económico se juega en el terreno de la inteligencia artificial aplicada. No obstante, la expresión más frecuente en el ámbito de data science es machine learning y, desde hace unos años, la que más impresiona es deep learning.

Seguro que han leído u oído esos conceptos en más de una ocasión y, quizás, no saben muy bien que significan o qué implican. Espero que este post les pueda aportar un poco más de conocimiento básico en torno a las tres disciplinas que harán realidad la ciencia ficción.

De manera formal la inteligencia artificial tiene dos denominaciones: aplicada y robusta (Strong AI). La inteligencia artificial robusta se ubica en el futuro, estaremos en ella cuando las máquinas puedan ejecutar todas las habilidades cognitivas de los humanos, algo que los expertos no consideran que pueda ocurrir en los próximos años.

Nuestro momento actual gira alrededor de la inteligencia artificial aplicada (Applied AI o también llamada Narrow AI o Weak AI). Machine learning y deep learning entran dentro de la órbita de Applied AI.

Machine learning (ML) o aprendizaje automático es, como dijo Paco Nathan hace unos días en la conferencia Big Data Spain, la herramienta que usan los equipos de data science para encontrar la proverbial aguja en el pajar. De forma sintética se trata de sistemas que autoaprenden a base de datos (muchos datos) sin necesidad de programación adicional (aunque hay sistemas híbridos). Han pasado dieciséis años desde que Google aplicó Page Rank, el algoritmo que intentaba averiguar lo que cada usuario estaba buscando. Google, el rey de la innovación, no inventó machine learning pero sí sentó las bases de su uso masivo. Machine learning es el sustento de los sistemas de recomendaciones (Amazon, eBay, LinkedIn, Twitter), de detección de fraude, de reconocimiento de voz, de algoritmos para la predicción de enfermedades, delitos, averías en máquinas o tendencias de consumo.

Pero desde el año pasado la conversación sobre inteligencia artificial se ha ido intensificando alrededor de un término inquietante, deep learning (aprendizaje profundo). En 2014 Google compró DeepMind, pagó 400 millones de dólares por una startup de 50 personas. Actualmente son 100 y es la empresa con el mayor número de expertos en deep learning del mundo. Twitter compró MadBits una startup de inteligencia visual capaz de entender el significado de las imágenes y sus correlaciones. Apple acaba de comprar ( 5 de octubre) la empresa Perceptio que usa AI para clasificar fotos. Debo citar también a Facebook que en su última F8 (conferencia de desarrolladores, en marzo de este año) anunció las últimas capacidades de la empresa en inteligencia artificial. Sus sistemas no solo pueden reconocer imágenes, sino también acciones en vídeos (por ejemplo deportes) y pueden responder a preguntas sobre textos (VB).

Neuronas artificiales

Deep learning es un paso más en machine learning, en el aprendizaje automático de las máquinas. Integra el análisis algorítmico de imágenes, lenguaje natural y datos con sistemas de resolución de problemas. Aunque las investigaciones avanzadas en torno a deep learning se remontan a la década de los ochenta, el ritmo de desarrollo ha sido impresionante en los últimos años. En 2012, el equipo de Google Brain logró el reconocimiento de imágenes usando 16.000 ordenadores en paralelo. Lo que Google consiguió fue reconocer un gato sobre la base de 10 millones de imágenes digitales tomadas de los videos de YouTube. Actualmente los algoritmos son 400 % más precisos utilizando tan sólo un PC y la GPU.

En una entrevista en Recode, el científico Andrew Ng (actual científico jefe de Baidu, profesor de Stanford y ex Google Brain) explica con bastante sencillez el concepto deep learning

“Es una tecnología de aprendizaje que funciona simulando libremente el cerebro. Tu cerebro y el mío trabajan debido a grandes cantidades de neuronas hablando entre sí. Deep learning funciona mediante la simulación de cientos de miles de millones de neuronas, simuladas por la computadora, hablando entre sí”.

Se trata de suministrar capas de neuronas artificiales a las máquinas para absorber datos del mundo, reconocer patrones en esos datos, clasificarlos y categorizarlos. Es conseguir que la máquina actúen como los seres humanos. Si a un niño le decimos que lo que ve es un gato, inmediatamente lo etiqueta con ese nombre y la próxima vez que el niño vea un gato sabrá que es un gato.

Uno de los ejemplos más populares de aplicación de deep learning se produjo en el transcurso de una charla del científico jefe de Microsoft Richard F. Rashid en China (2012). Su voz comenzó a ser transcrita, en directo, en chino mandarín en tiempo real (vídeo en Youtube).

El aprendizaje profundo ya se está en nuestro día a día, por ejemplo cuando usamos asistentes personales como Siri o Cortana, Street View o la traducción automática de Skype. Deep learning está en los coches y vehículos aeroespaciales autónomos (autotripulados), en los sistemas de reconocimiento de imágenes o faciales, en robots, en la plataforma cognitiva Watson de IBM, en marketing (aplicando al comportamiento humano) o en medicina. Uno de los ámbitos más espectaculares de aplicación de deep learning será, sin duda, el sanitario.

A finales de 2014 , Jeremy Howard abandonó la presidencia de Kaggle (la mayor comunidad de científicos de datos del mundo) para fundar Enlitic con el convencimiento de que utilizando la ingente cantidad de datos médicos (radiografías, notas médicas o pruebas de laboratorio) las computadoras pueden hacer diagnósticos médicos de forma más rápida, más precisa y más accesible que los propios médicos. Para ello Enlitic está desarrollando un algoritmo de deep learning en colaboración con hospitales y fabricantes de dispositivos médicos.

Fue precisamente en Kaggle, en 2012, donde un equipo de científicos, capitaneados por Geoffrey E. Hinton, ganó una competición de la farmacéutica Merck para encontrar moléculas que permitieran crear nuevos medicamentos. El equipo tardó solo dos semanas en encontrar esas moléculas. Ningún miembro tenía formación en Biología, Química o Ciencias de la Vida, tan solo aplicaron deep learning.

Todas las grandes compañías tecnológicas del mundo se han lanzado a una frenética carrera de investigación en este ámbito de las redes neuronales. Los resultados serán de gran transcendencia para la humanidad, pero el lado oscuro de la inteligencia artificial es, también, muy oscuro. Por ejemplo lean este artículo: Los coches autónomos pueden ser programados para matar (en inglés).

En enero de este año el Instituto Future of Live organizó en San Juán de Puerto Rico, una reunión de cuatro días, con más de cuarenta expertos y líderes mundiales, para hablar de los desafíos y oportunidades de la Inteligencia Artificial. Un encuentro a puerta cerrada, sin medios de comunicación y con el compromiso de no difundir lo hablado sin permiso. Entre los presentes: Elon Musk, Jaan Tallinn, Nick Bostrom, Andrew McAfee, Demis Hassabis, Peter Norvig, Eric Horvitz, Shane Leggo o Erik Brynjolfsson. Al final del encuentro los delegados firmaron una carta abierta comprometiéndose a investigar sólo para hacer el bien y evitar peligros potenciales.

El listado de asistentes así como algunas de las presentaciones están accesibles desde este enlace: Futureoflife.org.

Además de las ya referenciadas, para escribir este post he usado las siguientes fuentes de información:

Cronista compulsiva.

Periodista por vocación y de formación.

Consultora NTIC por experiencia.

Mi pasión es mi hija. Me gusta el café.

Cronista compulsiva.

Periodista por vocación y de formación.

Consultora NTIC por experiencia.

Mi pasión es mi hija. Me gusta el café.